Par le Dr Venkat Mattela, fondateur et PDG, Ceremorphic

Avec la croissance et l'adoption généralisée des applications d'intelligence artificielle (IA) et d'apprentissage automatique dans tous les segments industriels, au milieu de l'avènement de toutes les technologies, les supercalculateurs ont fait leur marque. Ils sont maintenant utilisés dans presque tous les aspects de notre vie, du développement de médicaments à la prévision météorologique et aux jeux en ligne. Les superordinateurs avec leur incroyable intelligence peuvent être capables de sauver le monde, mais à mesure que leurs performances s'améliorent, leurs besoins en énergie se rapprochent de ceux d'une petite ville. Il n'est pas exagéré d'affirmer que l'industrie des semi-conducteurs rend la vie moderne possible. Plus de 100 milliards de circuits intégrés sont utilisés quotidiennement à l'échelle internationale, et la demande ne cesse de croître : grâce en grande partie aux avancées des marchés en développement rapide de l'intelligence artificielle (IA), des véhicules autonomes et de l'Internet des objets.

Jusqu'à présent, l'industrie a réussi à fournir des puces intégrées plus puissantes en réponse à la demande. Mais avec la consommation massive et croissante de données chaque jour, les environnements de supercalcul sont de plus en plus courants dans la vie quotidienne d'aujourd'hui et, par conséquent, leur infrastructure complexe rend le dépannage et la surveillance des pannes extrêmement difficiles. En effet, ces infrastructures contiennent des milliers de nœuds qui représentent diverses applications et processeurs. Pour répondre à ces préoccupations, un cadre d'analyse de fiabilité en temps réel pour les environnements informatiques à performances fiables est nécessaire. Il y a un besoin imminent de résoudre les problèmes de fiabilité, de sécurité et de consommation d'énergie auxquels sont actuellement confrontés le calcul haute performance.

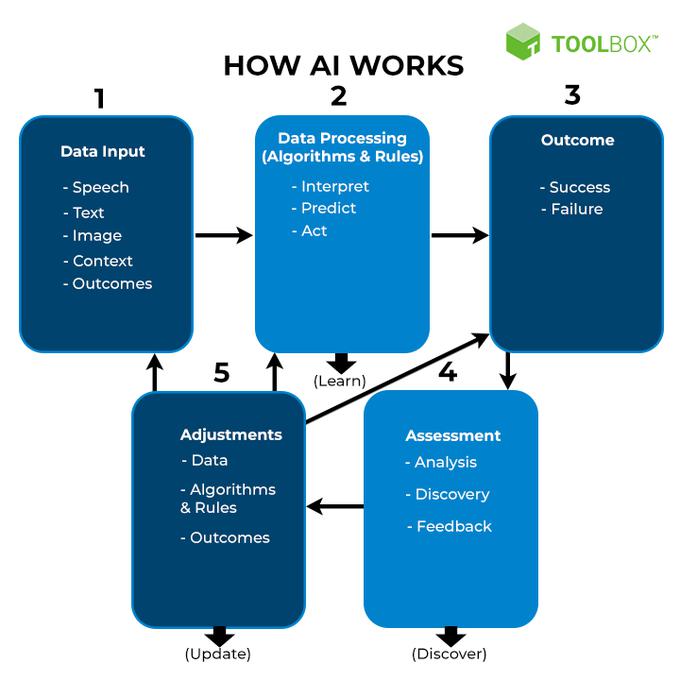

Par exemple, pendant la pandémie, le calcul haute performance a fourni un accès gratuit aux ordinateurs les plus puissants du monde aux chercheurs qui luttaient contre le COVID-19. Les chercheurs et les institutions ont utilisé des superordinateurs pour suivre la propagation de Covid-19 en temps réel et ont également pu prédire où le virus se propagerait en identifiant des modèles et en examinant comment des mesures préventives telles que la distanciation sociale aidaient. La quantité de calcul nécessaire à cette échelle mondiale n'a été rendue possible que grâce au calcul haute performance, également connu sous le nom de HPC. Le calcul haute performance (HPC) permet aux entreprises de se développer en termes de calcul pour développer des algorithmes d'apprentissage en profondeur capables de gérer des quantités de données exponentiellement importantes. Cependant, avec plus de données vient la demande de plus de puissance informatique et de spécifications de performances plus élevées. Et du coup, on assiste aujourd'hui à la fusion du HPC avec l'Intelligence Artificielle, inaugurant ainsi une nouvelle ère !

Des performances plus élevées nécessitent plus d'énergie, c'est pourquoi elles sont ingérables si nous adoptons l'approche traditionnelle pour obtenir des performances plus élevées. Développer des algorithmes avancés pour réduire la charge de travail effective est une approche novatrice de la consommation d'énergie est l'une des solutions. . Cependant, dans la nouvelle ère d'aujourd'hui où le calcul est abondant et l'intelligence artificielle rendant la défense de la sécurité encore plus difficile, l'architecture doit être conçue pour contrer les menaces futures et permettre de nouveaux traitements IA / ML. Une autre opportunité de mise à l'échelle vers laquelle l'industrie des semi-conducteurs s'oriente est l'architecture de circuit personnalisée à faible puissance pour les liaisons courtes à haut débit. L'industrie a aujourd'hui besoin d'une nouvelle architecture fiable qui utilise la logique et l'apprentissage automatique pour détecter et corriger les défauts en utilisant le meilleur matériel et logiciel disponible.

Il est communément admis dans les circuits traditionnels que pour rendre les choses plus rapides, il faut utiliser plus d'énergie. La vitesse et la puissance sont des adversaires constants. Cependant, de nombreuses stratégies qui aident à réduire la consommation d'énergie de l'IA contribuent également à améliorer les performances. Par exemple, en gardant les données locales ou stationnaires, vous pouvez économiser de l'énergie tout en évitant les additionneurs de latence des récupérations de données. La parcimonie minimise le niveau de calcul requis, vous permettant de terminer la charge de travail plus rapidement. En termes simples - Moins de calcul et moins de mouvement de données signifient moins d'énergie consommée. Le Machine Learning est aussi une manière alternative de résoudre des problèmes avec beaucoup plus d'efficacité énergétique (énergie, performance à faible coût, etc.).

À l'heure actuelle, la feuille de route de la technologie des semi-conducteurs fournit des outils et des nœuds pour le développement de produits en silicium avancés, afin de répondre à cette demande massive de calcul haute performance et le nœud 5 nm est très efficace pour fournir une densité de grille élevée (environ 40 M portes dans une zone de 1 mm²). Avec cela, une entreprise peut essentiellement fabriquer des puces très complexes et performantes dans une taille physique raisonnable si elle a accès à ce type de nœud technologique. Cependant, ces nœuds posent un défi en termes de gestion de la puissance de fuite et de la fiabilité. Et ces deux défis, la fiabilité et l'efficacité énergétique, font actuellement obstacle à la généralisation de la haute performance dans l'espace IA/Machine Learning.

Alors que l'échelle et la complexité ont augmenté, de nouveaux défis en matière de fiabilité et de résilience systémique, d'efficacité énergétique, d'optimisation et de complexité logicielle sont apparus, ce qui implique que les approches actuelles doivent être réévaluées. Bien qu'il y ait eu beaucoup d'enthousiasme pour l'utilisation des nouvelles technologies, à la fois dans le matériel informatique et les technologies de refroidissement, la plupart des utilisateurs se concentrent toujours sur l'exploitation des ressources plus traditionnelles à leur disposition.

Publicité