Par Rachel Schraerhealth and Disinformation Reporter

- Published

Comment résolvez-vous un problème comme de mauvaises informations?

Quand il s'agit de comprendre la science et de prendre des décisions de santé, il peut avoir des conséquences sur la vie ou la mort.

Les personnes dissuadées de prendre des vaccins à la suite de la lecture d'informations trompeuses en ligne se sont retrouvées à l'hôpital ou sont décédées.

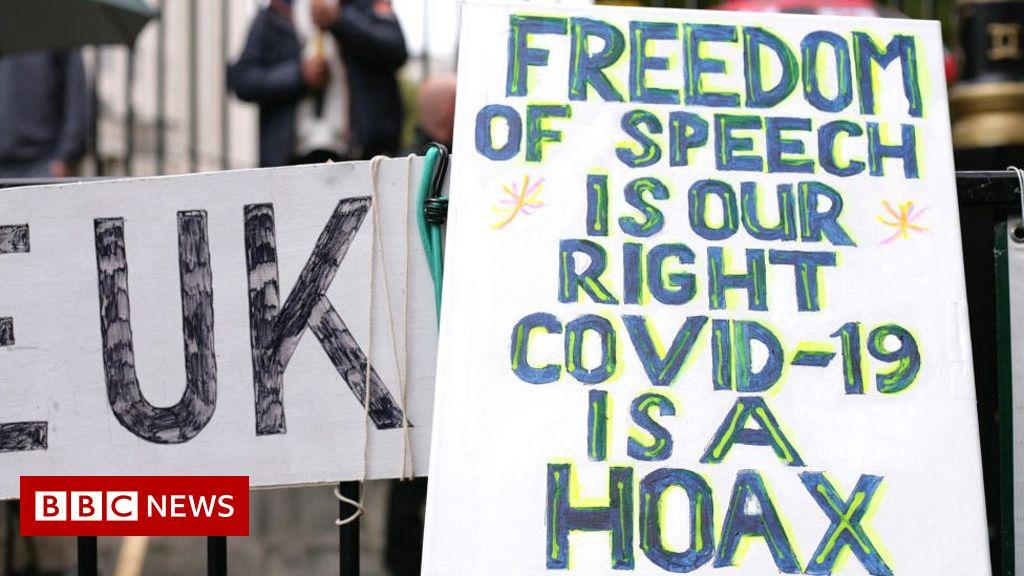

Et des revendications inexactes ou entièrement inventées environ la 5G et les origines de Covid-19 ont été liées à la violence et au vandalisme.

Mais supprimer complètement les informations peut ressembler beaucoup à la censure, en particulier pour les scientifiques dont les carrières sont basées sur la compréhension que les faits peuvent et doivent être contestés, et que les preuves changent.

La Royal Society est la plus ancienne institution scientifique en constante évolution au monde, et il tente de relever les défis posés par nos dernières façons de communiquer.

Dans un nouveau rapport, il conseille les sociétés de médias sociaux supprimant le contenu qui est "légal mais nuisible".Au lieu de cela, les auteurs du rapport pensent que les sites de médias sociaux devraient ajuster leurs algorithmes pour empêcher qu'il devienne viral - et empêcher les gens de gagner de l'argent sur de fausses réclamations.

Mais tout le monde n'est pas d'accord avec ce point de vue - en particulier les chercheurs qui sont des experts dans le suivi de la façon dont la désinformation se propage en ligne, et comment cela nuit aux gens.

Le Center for Counter Digital Hate (CCDH) maintient qu'il y a des cas où la meilleure chose à faire est de supprimer le contenu lorsqu'il est très nocif, clairement faux et se propage très largement.

L'équipe pointe vers la Plancémique - une vidéo qui est devenue virale au début de la pandémie, faisant des affirmations dangereuses et fausses conçues pour effrayer les gens des moyens efficaces de réduire les dommages du virus, comme les vaccins et les masques, et a finalement été abattu.

Les sociétés de médias sociaux ont été mieux préparées pour la suite de la vidéo Planchemic 2, qui est tombée à plat après avoir été limitée sur les principales plateformes, n'ayant rien de tel que la première vidéo que la première vidéo.

"C'est une question politique...Quel équilibre nous voyons entre les libertés individuelles et une forme de restrictions sur ce que les gens peuvent et ne peuvent pas dire ", explique le professeur Rasmus Kleis Nielsen, directeur du Reuters Institute for the Study of Journalism à l'Université d'Oxford.

Le professeur Nielsen reconnaît que, bien qu'il s'agisse d'une partie relativement faible des régimes médiatiques des gens, la désinformation scientifique peut entraîner un préjudice disproportionné.

Mais, ajoute-t-il, étant donné un manque de confiance dans les institutions est un grand moteur de désinformation: "J'imagine qu'il y a beaucoup de citoyens qui auraient leurs pires soupçons confirmés sur le fonctionnement de la société, si les institutions établies prenaient beaucoup plus de mains-Un rôle dans la limitation de l'accès des gens à l'information."

'Plus difficile à atteindre'

Faisant écho à cette préoccupation, la Royal Society dit: "La suppression du contenu peut exacerber les sentiments de méfiance et être exploités par d'autres pour promouvoir le contenu de désinformation."Ce" peut causer plus de mal que de bien en entraînant un contenu de désinformation...Vers les coins plus durs d'adressage d'Internet."

Le fait que ces coins soient "plus difficiles à atteindre", cependant, fait sans doute partie du point.Cela réduit le risque que une personne qui ne soit pas déjà déterminée à des croyances potentiellement nocives et ne les cherche pas, sera exposée à lui par hasard.

Certaines des protestations violentes qui ont été motivées au moins en partie par des complots n'avaient pas leur origine dans les coins obscurs d'Internet, mais sur Facebook.Et il y a peu de preuves claires que la suppression du contenu pousse les gens davantage aux croyances nuisibles.

Changer l'algorithme

La désinformation scientifique n'a rien de nouveau.

La croyance incorrecte en un lien entre le vaccin ROR et l'autisme est venue d'un document académique publié (et rétracté), tandis que des croyances généralisées non apprises dans le préjudice de la fluoration de l'eau ont été motivées par les médias imprimés, les groupes de campagne et le bouche à bouche.

Ce qui a changé, c'est la vitesse à laquelle les faux faits voyagent, et le grand nombre de personnes qui peuvent finir par les lire.

Plutôt que de supprimer le contenu, une façon suggérée par les auteurs du rapport de lutter.

Ceci, a expliqué le professeur Gina Neff, un spécialiste des sciences sociales de l'Oxford Internet Institute, devait "s'assurer que les gens peuvent toujours exprimer leur esprit" - ils ne sont tout simplement pas garantis d'un public de millions.

"Ils peuvent toujours publier ces informations, mais les plateformes n'ont pas à le rendre viral."

Vérification des faits

L'Institut de dialogue stratégique (ISD), un groupe de réflexion qui surveille l'extrémisme, souligne une proportion substantielle de désinformation repose sur l'appropriation et la mauvaise utilisation des données et des recherches authentiques.

"C'est parfois plus dangereux que les fausses informations carrément, car cela peut prendre beaucoup plus de temps pour démystifier en expliquant comment et pourquoi il s'agit d'une mauvaise lecture ou d'une mauvaise utilisation des données", dit son porte-parole.

C'est là que la vérification des faits se produit - un autre outil que la Royal Society soutient.

L'une des pièces de désinformation des vaccins les plus courantes au cours de la dernière année - que la BBC a vérifié à plusieurs reprises - était la notion que les gens sont blessés en grand nombre par le JAB.Cette affirmation est basée sur une interprétation erronée de figures réelles.

Les individus de plate-forme

L'ISD affirme que la recherche a montré qu'un petit groupe de comptes répandant une désinformation a eu une "influence disproportionnée sur le débat public sur les réseaux sociaux".

"Beaucoup de ces comptes ont été étiquetés par des vérifications de faits comme partageant du contenu faux ou trompeur à plusieurs reprises, mais restent en direct."

La Royal Society n'a pas enquêté sur la suppression des comptes des «influenceurs» qui sont des écarts particulièrement prolifiques de désinformation nuisible.

Mais cela est considéré comme un outil important par de nombreux experts en désinformation, et la recherche sur l'Etat islamique et l'extrême droite suggère qu'il peut réussir.

Lorsque David Icke, un épandeur prolifique de désinformation covide ainsi que des théories du complot antisémite, a été supprimé de YouTube, la recherche du CCDH a constaté que sa capacité à atteindre les gens était considérablement réduite.

Alors que ses vidéos sont restées sur la plate-forme d'hébergement vidéo alternative Bitchute, leurs vues sont passées de 150 000 en moyenne avant l'interdiction de YouTube à 6 711 après.Sur YouTube, 64 de ses vidéos avaient été visionnées 9.6 millions de fois.

La recherche de l'Université de Cardiff, a révélé que la plate-forme de Kate Shemirani, ancienne infirmière et épandeur prolifique de la désinformation covide, a diminué sa portée à court terme.

"Une partie du problème est que les modèles actuels de la plate-information doivent être développés.Il ne suffit pas de simplement éliminer un morceau de contenu, ou un petit nombre de comptes, "l'un des auteurs du journal - le professeur Martin Innes - explique.

La recherche du crime organisé et du contre-terrorisme montre la nécessité de perturber l'ensemble du réseau, dit-il.

Mais il croit que "ce niveau de sophistication n'est pas encore ancré" dans la façon dont nous abordons la désinformation qui pourrait mettre les gens en danger.