iOS 15

apporte une nouvelle intelligence à votre téléphone sous la forme de texte en direct et de recherche visuelle. Les deux fonctionnalités s'appuient fortement sur le moteur neuronal qui fait partie du processeur de votre iPhone et travaillent pour transformer l'appareil photo du téléphone en un appareil qui ne se contente pas de capturer des images, mais peut également analyser le contenu des photos et vous permettre d'en faire plus avec ces informations.

Avec le texte en direct d'iOS 15, votre appareil photo peut désormais capturer et copier du texte dans des images, vous permettant de coller le texte dans des documents, des messages et des e-mails. Vous pouvez même rechercher des adresses Web et composer des numéros de téléphone qui apparaissent sur vos photos. Pendant ce temps, Visual Look Up est un excellent moyen d'en savoir plus sur le monde qui vous entoure, car vous pouvez balayer votre photo vers le haut pour rechercher des informations sur des points de repère, des peintures, des livres, des fleurs et des animaux.

Examen de la version bêta d'iOS 15

: Ce que nous pensons jusqu'à présent

Voici les

meilleurs téléphones avec appareil photo

Plus:

Comment télécharger la version bêta publique d'iOS 15

Si cela vous semble familier, c'est parce que Google a proposé des fonctionnalités similaires via Google Lens, qui est intégré à sa propre application Photos et a été déployé sur de nombreux téléphones Android. Apple n'hésite jamais à ajouter des fonctionnalités que les entreprises concurrentes ont commencées, en particulier si elles peuvent présenter ces fonctionnalités (ce qu'elles pensent) comme une meilleure façon.

Il faudra attendre la sortie de la version complète d'iOS 15 à l'automne pour voir si Apple a réussi. Mais en utilisant la version bêta publique d'iOS 15, nous pouvons voir à quel point le texte en direct et la recherche visuelle sont avancés, en particulier par rapport à ce qui est disponible sur les téléphones Android via Google. Mais d'abord, examinons de plus près ce que Live Text et Visual Look Up apportent à l'iPhone dans la mise à jour iOS 15.

Texte en direct iOS 15 : ce que vous pouvez faire et comment cela fonctionne

Avant de commencer avec Live Text ou Visual Look Up, vous devez vous assurer que vous disposez d'un téléphone compatible - et dans ce cas, être capable d'exécuter iOS 15 ne suffit pas. Parce que ces deux fonctionnalités dépendent fortement du traitement neuronal,

vous aurez besoin d'un appareil alimenté par au moins une puce A12 Bionic

, ce qui signifie que le

iPhone XR

,

iPhone XS

, ou iPhone XS Max, ainsi que tout téléphone sorti après ce trio de 2018.

Live Text est capable de reconnaître toutes sortes de textes, qu'il s'agisse de texte imprimé sur une photo, d'écriture manuscrite sur une feuille de papier ou de gribouillis sur un tableau blanc. La fonctionnalité ne fonctionne pas seulement dans Photos, mais également dans les captures d'écran, Quick Look et même les images que vous rencontrez lors de la navigation dans Safari. Au lancement d'iOS 15, Live Text prendra en charge sept langues - en plus de l'anglais, il reconnaîtra le chinois, le portugais, le français, l'italien, l'espagnol et l'allemand.

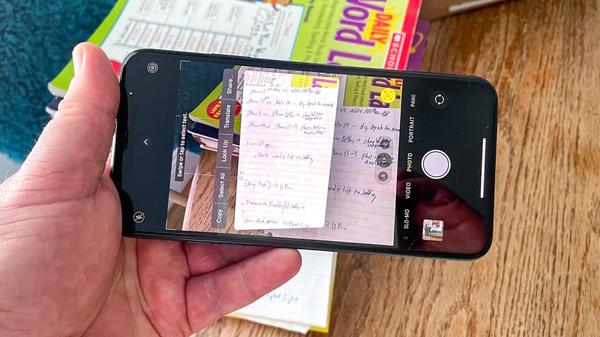

L'application Appareil photo d'iOS 15 offre un aperçu de ce que Live Text capture ; appuyez simplement sur l'icône de texte dans le coin inférieur droit du viseur. À partir de là, vous pouvez sélectionner du texte à copier, traduire, regarder ou partager avec d'autres personnes. Aussi utile que cela soit, je pense que l'utilisation la plus pratique consistera à sélectionner du texte à partir de photos déjà présentes dans votre photothèque.

La fonctionnalité capture plus que du texte. Vous pouvez également collecter des numéros de téléphone, et une longue pression sur le numéro de téléphone sur une photo fait apparaître un menu qui vous permet d'appeler, d'envoyer un SMS ou FaceTime avec le numéro ; vous pouvez également ajouter ce numéro à votre application Contacts en un clic. (La fonctionnalité fonctionne également dans l'aperçu en direct de l'application Appareil photo - appuyez simplement sur le bouton de texte dans le coin inférieur, puis appuyez longuement sur le numéro.) Une chose similaire se produit lorsque vous appuyez longuement sur une adresse Web (vous avez la possibilité d'ouvrir un lien dans votre navigateur mobile) ou une adresse physique (vous pouvez obtenir un itinéraire dans Maps).

Recherche visuelle iOS 15 : ce que vous pouvez faire et comment cela fonctionne

Visual Look Up est un moyen d'obtenir plus d'informations sur tout ce que vous prenez en photo. La fonctionnalité est pratique pour rechercher des informations de fond sur tous les sites et points d'intérêt que vous avez visités lors de vacances passées, mais elle est également utile pour en savoir plus sur les livres, les plantes et d'autres objets.

Accédez à l'application Photos dans iOS 15 et sélectionnez une photo. Habituellement, vous devrez balayer vers le haut, ce qui révélera des détails sur l'image, tels que l'endroit où vous l'avez prise, sur quel appareil, etc. Mais si Visual Look Up a quelque chose à ajouter, une icône apparaîtra sur la photo elle-même. Appuyez dessus et vous verrez une collection de liens Siri et d'images similaires du Web qui peuvent vous en dire plus sur ce que vous regardez.

L'icône sur laquelle vous appuyez change en fonction de ce que vous recherchez avec Visual Look Up. Une peinture produira une icône de type artistique, tandis qu'une feuille indique que Visual Look Up peut partager des informations sur les plantes.

Vous n'avez pas besoin d'avoir pris les photos récemment ou même par un iPhone pour que Visual Look Up les reconnaisse. Une image de moi prise avec un Canon PowerShot S200 debout devant le Tower Bridge de Londres il y a 12 ans a été reconnue. Mais Visual Look Up peut être une sorte de hasard à ce stade, car Apple étoffe la fonctionnalité pour la version finale d'iOS 15. Parfois, vous obtiendrez des informations; parfois, vous ne serez pas.

Texte en direct iOS 15 et recherche visuelle par rapport à Google Lens : comment ils se comparent

Pour savoir comment les efforts initiaux d'Apple se comparent à ce que les utilisateurs d'Android apprécient actuellement, je me suis promené dans San Francisco, armé d'un

iPhone 11 Pro Max

exécutant la version bêta d'iOS 15 et un

GooglePixel 4a 5G

sous Android 11. J'ai pris les photos, je suis rentré chez moi et j'ai fait mes comparaisons là-bas plutôt que de vivre sur le terrain. Voici ce que nous avons trouvé.

Capture de texte :

Avant de m'arrêter pour déjeuner dans l'un de mes restaurants préférés, j'ai pris une photo de l'extérieur du restaurant. J'ai dû zoomer sur la photo de l'iPhone pour m'assurer que je capturais le texte voulu, mais Live Text a réussi à copier le mot Cheeseburger, même s'il apparaît en biais dans le signe. (Cela a ajouté une parenthèse superflue, mais que pouvez-vous faire?) Live Text a également saisi le texte manuscrit promettant Baileys & Irish Coffee Hot Toddy, bien qu'il ait trébuché en traduisant cette esperluette.

Ce que Live Text a capturé (à gauche) et ce que Live Text a copié (à droite)

Google Lens a reconnu avec succès l'esperluette dans le signe manuscrit et a également pu capturer le texte du cheeseburger. Cependant, j'ai trouvé que les commandes de sélection de texte pour cette image particulière étaient moins précises. Le signe manuscrit a également copié le texte du logo des Giants tandis que j'ai également dû copier l'intégralité du texte du signe Cheeseburger. Dans ce test au moins, Live Text tient tête à Google Lens.

Ce que Google Lens a capturé (à gauche) et ce que Google Lens a copié (à droite)

Les numéros de téléphone:

Pour tester la possibilité d'appeler des numéros de téléphone que j'avais capturés avec l'appareil photo de mon téléphone, j'ai pris une photo d'un panneau de stationnement. Je ne trouve pas que l'appui long de Live Text sur le numéro soit une fonctionnalité particulièrement intuitive, mais le menu contextuel est apparu sans problème. Google Lens était un peu plus pointilleux. J'ai dû sélectionner avec soin le texte du numéro de téléphone, indicatif régional inclus - ce n'est qu'alors qu'une option d'appel est apparue dans le menu. Je pense qu'Apple a peut-être trouvé une solution plus élégante que Google ici.

Live Text (à gauche) vs Google Lens (à droite) reconnaissant les numéros de téléphone

Écriture:

Nous avons déjà vu Live Text et Google Lens montrer leurs trucs avec du texte écrit sur la signalisation Red's Java Hut, mais qu'en est-il de l'écriture manuscrite réelle ? Savoir que vous pouvez facilement copier votre écriture dans des notes peut être un véritable gain de temps lorsqu'il s'agit de transcrire des notes de conférences, de réunions ou de sections de brainstorming.

Je décrirais mon propre style d'écriture comme "une note de rançon griffonnée à la hâte", donc la capturer est tout un test pour Live Text et Google Lens. C'est une tâche que Live Text n'est tout simplement pas à la hauteur. Tout d'abord, comme vous pouvez le voir sur la capture d'écran, elle n'a capturé que toutes les autres lignes de mes notes sur les histoires potentielles de l'iPhone 11 à partir de 2019. Le texte que j'ai pu coller dans Notes n'incluait pas un mot réel de ce que j'avais écrit - d'une manière ou d'une autre, "Features to Enable/Disable" est devenu "Fatboris ta Enalla/Dinlille 7". Retour à la planche à dessin avec cette fonctionnalité, je pense.

Ce que Live Text a capturé (à gauche) et ce qu'il a transcrit (à droite)

Google Lens s'en sort mieux ici, mais seulement de justesse. Il capture la plupart, mais pas la totalité, du texte manuscrit (et une partie du texte des livres en arrière-plan). Les notes collées ressemblent au langage humain réel, avec quelques erreurs de traduction. ("Disable" devient "Disalle".) Ce n'est pas parfait, mais c'est beaucoup plus avancé que ce qu'Apple a à offrir.

Ce que Google Lens a capturé (à gauche) et ce qu'il a transcrit (à droite)

URL :

Nous avons pu tester la capacité de Live Text et de Google Lens à rechercher des adresses Web ou physiques, et j'ai décidé d'opter pour la première. Un appui long sur l'URL dans Photos m'a donné la possibilité d'ouvrir un lien dans Safari ; Je pourrais également appuyer sur un bouton Live Text sur l'image et appuyer sur l'URL pour accéder automatiquement à Safari. De même, Google Lens sur le Pixel 4a a reconnu le texte et m'a présenté un bouton qui m'a amené à la bonne URL dans Chrome. Cette fonctionnalité fonctionne aussi bien sur les deux téléphones.

Live Text (à gauche) vs Google Lens (à droite) reconnaissant les adresses Web

Affiche de film:

En ce qui concerne Visual Look Up, il est peut-être capable de reconnaître des livres – il a identifié avec succès la biographie de Robin Williams de David Itzkoff, même en créant des liens vers des critiques – mais les affiches de films semblent le déconcerter. Une photo de l'affiche de Black Widow à l'extérieur de mon cineplex local n'a donné aucune information supplémentaire sur l'iPhone. Même si ce n'est pas la meilleure des photos, Google Lens sur le Pixel 4a a toujours fourni des liens vers des critiques et des images similaires.

iOS 15 Visual Look Up (à gauche) par rapport à Google Lens (à droite)

Bâtiments:

Je n'ai vu le Ferry Building que de loin lors de ma promenade dans San Francisco, mais j'ai pensé que ce serait un bon test pour déterminer jusqu'où la vision de Visual Look Up peut atteindre. La réponse n'est pas aussi loin que cela, apparemment, car je n'ai pas obtenu d'informations sur ce luminaire assez reconnaissable de San Francisco. Google Lens n'a eu aucun problème, mauvais angle et tout.

iOS 15 Visual Look Up (à gauche) par rapport à Google Lens (à droite)

Repère:

Au moins Visual Look Up peut reconnaître les points de repère à distance. Même depuis le rivage, la nouvelle fonctionnalité d'iOS 15 pourrait extraire des informations sur le Bay Bridge, offrant même un résumé Siri Knowledge des spécifications du pont. Les résultats de Google Lens se concentraient davantage sur les images, bien qu'il y ait un lien de recherche qui m'a amené aux résultats de Google.

iOS 15 Visual Look Up (à gauche) par rapport à Google Lens (à droite)

Statue:

J'ai le regret de vous informer que les nouvelles des réalisations de Willie Mays n'ont pas encore atteint Visual Look Up. La fonctionnalité d'iOS 15 a produit des images Web similaires - une série de statues sans rapport - mais rien d'autre. En plus d'un lien de recherche Google, les images similaires produites par Google Lens présentaient au moins d'autres grands du baseball... y compris des statues d'autres géants autour du même endroit que la statue de Willie Mays.

iOS 15 Visual Look Up (à gauche) par rapport à Google Lens (à droite)

Ouvrages d'art:

Visual Look Up ne connaît peut-être pas le baseball, mais il comprend certainement l'art. Une photo de Rosseau

L'Enfant à la poupée

a mis en place des liens Siri Knowledge non seulement vers l'œuvre d'art, mais aussi vers l'artiste. Google Lens a proposé son assortiment habituel d'images similaires et le lien de recherche omniprésent. Les résultats d'Apple ont été plus éclairants.

La vie végétale:

J'ai obtenu des résultats mitigés lorsque j'ai installé Visual Look Up dans mon jardin. La fonctionnalité iOS 15 a correctement identifié la sauge mexicaine dans mon jardin, mais elle semble penser que le pommier que j'ai fait pousser des prunes. Google Lens a correctement identifié les deux plantes et a même essayé de déterminer quel type de pommes poussent sur mon arbre.

Visual Look Up a correctement identifié la sauge mexicaine (à gauche) mais est tombé sur des pommes (à droite).

Texte en direct et recherche visuelle d'iOS 15 par rapport à Google Lens : premier verdict

iOS 15 est peut-être en version bêta, mais Live Text se compare favorablement à Google Lens dans à peu près tout sauf la transcription de texte manuscrit. C'est quelque chose qu'Apple peut probablement affiner d'ici la sortie de la version finale d'iOS 15, bien que Google ait eu une longueur d'avance ici et que tout ne soit toujours pas complètement précis.

L'écart entre Visual Look Up et Google Lens est un peu plus grand, car les résultats de Visual Look Up peuvent être aléatoires. Quand il y a des informations, cependant, elles sont juste là dans le champ des résultats au lieu de vous envoyer à un moteur de recherche pour des données supplémentaires.

En d'autres termes, Live Text et Visual Look Up sont encore des bêtas. Mais vous ne pouvez qu'être impressionné par le travail initial d'Apple.

Meilleurs iPhone

Les meilleures offres Apple iPhone 12 Pro du jour

Des plans

Débloqué

Achetez 3 mois et obtenez 1 mois GRATUIT en utilisant le code promo SWITCH

Mint Mobile États-Unis

Pas de contrat

Apple iPhone 12 Pro (versements 128 Go)

Apple iPhone 12 Pro (versements 128 Go)

Libérer

à l'avant

56,62 $

/mois

Illimité

minutes

Illimité

les textes

4 Go

Les données

Appels:

Appels vers MX & CA inclus

Les textes:

Messagerie vers MX et CA incluse

Données:

(ralenti à des vitesses de 128kbps)

Mint Mobile États-Unis

Pas de contrat

Illimité

minutes

Illimité

les textes

4 Go

Les données

Appels:

Appels vers MX & CA inclus

Les textes:

Messagerie vers MX et CA incluse

Données:

(ralenti à des vitesses de 128kbps)

Voir l'offre

à

Mobile à la menthe

Libérer

à l'avant

56,62 $

/mois

Voir l'offre

à

Mobile à la menthe

Achetez 3 mois et obtenez 1 mois GRATUIT en utilisant le code promo SWITCH

Mint Mobile États-Unis

Pas de contrat

Apple iPhone 12 Pro (versements 256 Go)

Apple iPhone 12 Pro (versements 256 Go)

Libérer

à l'avant

60,79 $

/mois

Illimité

minutes

Illimité

les textes

4 Go

Les données

Appels:

Appels vers MX & CA inclus

Les textes:

Messagerie vers MX et CA incluse

Données:

(ralenti à des vitesses de 128kbps)

Mint Mobile États-Unis

Pas de contrat

Illimité

minutes

Illimité

les textes

4 Go

Les données

Appels:

Appels vers MX & CA inclus

Les textes:

Messagerie vers MX et CA incluse

Données:

(ralenti à des vitesses de 128kbps)

Voir l'offre

à

Mobile à la menthe

Libérer

à l'avant

60,79 $

/mois

Voir l'offre

à

Mobile à la menthe

Achetez 3 mois et obtenez 1 mois GRATUIT en utilisant le code promo SWITCH

Mint Mobile États-Unis

Pas de contrat

Apple iPhone 12 Pro (versements 128 Go)

Apple iPhone 12 Pro (versements 128 Go)

Libérer

à l'avant

$61.62

/mois

Illimité

minutes

Illimité

les textes

10 Go

Les données

Appels:

Appels vers MX & CA inclus

Les textes:

Messagerie vers MX et CA incluse

Données:

(ralenti à des vitesses de 128kbps)

Mint Mobile États-Unis

Pas de contrat

Illimité

minutes

Illimité

les textes

10 Go

Les données

Appels:

Appels vers MX & CA inclus

Les textes:

Messagerie vers MX et CA incluse

Données:

(ralenti à des vitesses de 128kbps)

Voir l'offre

à

Mobile à la menthe

Libérer

à l'avant

$61.62

/mois

Voir l'offre

à

Mobile à la menthe

Nous vérifions plus de 250 millions de produits chaque jour pour les meilleurs prix

Philippe Michaels

Philip Michaels est rédacteur en chef de Tom's Guide. Il a des opinions bien arrêtées sur Apple, les Oakland Athletics et les vieux films. Suivez-le sur @PhilipMichaels.