En utilisant des techniques de génération d'images contradictoires, nous combattons certains des derniers modèles de vision par ordinateur utilisés par les attaquants. Nous utilisons cette technique pour vaincre avec succès les modèles d'apprentissage automatique des attaquants, tout en minimisant les changements de pixels requis afin de ne pas nuire à la bonne expérience utilisateur. Lisez la suite pour voir comment cela fonctionne.

La vision par ordinateur donne aux machines le sens de la vue. Grâce aux progrès de l'intelligence artificielle, la vision par ordinateur a évolué à une vitesse vertigineuse ces dernières années. La technologie qui a rendu possible les véhicules autonomes est également largement utilisée par les fraudeurs pour indexer et classer automatiquement les images et vaincre les systèmes de sécurité Web qui incluent un défi visuel, nécessitant une interaction de l'utilisateur.

Manipuler les modèles ML des attaquants

Pour se défendre contre les attaques avancées basées sur l'apprentissage automatique sur les défis d'application d'Arkose Labs, nous avons introduit une nouvelle technique de génération d'images, appelée Adversarial Image Génération. Nous utilisons cette technique pour nous défendre contre certains des derniers modèles de vision par ordinateur utilisés par les attaquants. En utilisant des perturbations efficaces, cette technique réussit à vaincre les modèles d'apprentissage automatique des attaquants, tout en minimisant les changements de pixels requis.

Chez Arkose Labs, nous assistons à une myriade d'attaques. Pour se défendre contre une telle variété d'attaques, nous générons plusieurs ensembles d'images pour chaque puzzle. Chaque ensemble d'images a des paramètres uniques, tels que des arrière-plans, des styles ou des instructions différents. Ces différents paramètres aident à tromper les attaquants avec une distribution différente des pixels dans les images et des résultats différents.

Cela dit, les algorithmes d'apprentissage automatique sont efficaces pour prédire des données qu'ils n'ont jamais vues auparavant. Par conséquent, la méthode de génération d'image actuelle peut ne pas toujours fonctionner comme prévu. Par conséquent, nous avons développé une nouvelle méthode de génération d'images, qui ajoute une perturbation contradictoire sur les images pour manipuler la reconnaissance d'image des attaquants. Des recherches récentes ont démontré qu'il est facile de tromper les modèles d'apprentissage en profondeur avec un certain bruit sur les images.

.

Fig.1. Perturbation contradictoire (Réf : https://arxiv.org/pdf/1906.00204.pdf)

À l'origine, le modèle peut identifier correctement l'image. L'ajout de bruit contradictoire sur les images trompe complètement le modèle. Le modèle d'apprentissage automatique pouvait identifier correctement l'image originale comme une image d'ours polaire, mais s'est trompé en la voyant comme un lave-vaisselle après l'ajout du bruit.

Pour calculer la perturbation contradictoire, nous pouvons utiliser une méthode rapide basée sur le gradient et une méthode basée sur l'optimisation avec une approche d'ensemble. Diverses études dans ce domaine montrent qu'il est possible de transférer la perturbation, générée par l'approche d'ensemble, entre différents modèles de vision par ordinateur. Cette méthode est utilisée pour les images contradictoires pour se défendre contre différentes attaques d'apprentissage automatique.

Fig.2. Flux de travail de perturbation contradictoire

La génération d'images contradictoires est menée comme un cycle. La première étape consiste à générer les images contradictoires. La deuxième étape consiste à former les modèles formés avec des images contradictoires. Étant donné que les attaquants peuvent s'entraîner sur des images contradictoires, le flux continuera à générer des images contradictoires avec les modèles formés spécifiquement sur des images contradictoires auparavant. De cette façon, le flux peut augmenter et renforcer le bruit à chaque itération.

L'étude de cas "Hand Puzzle"

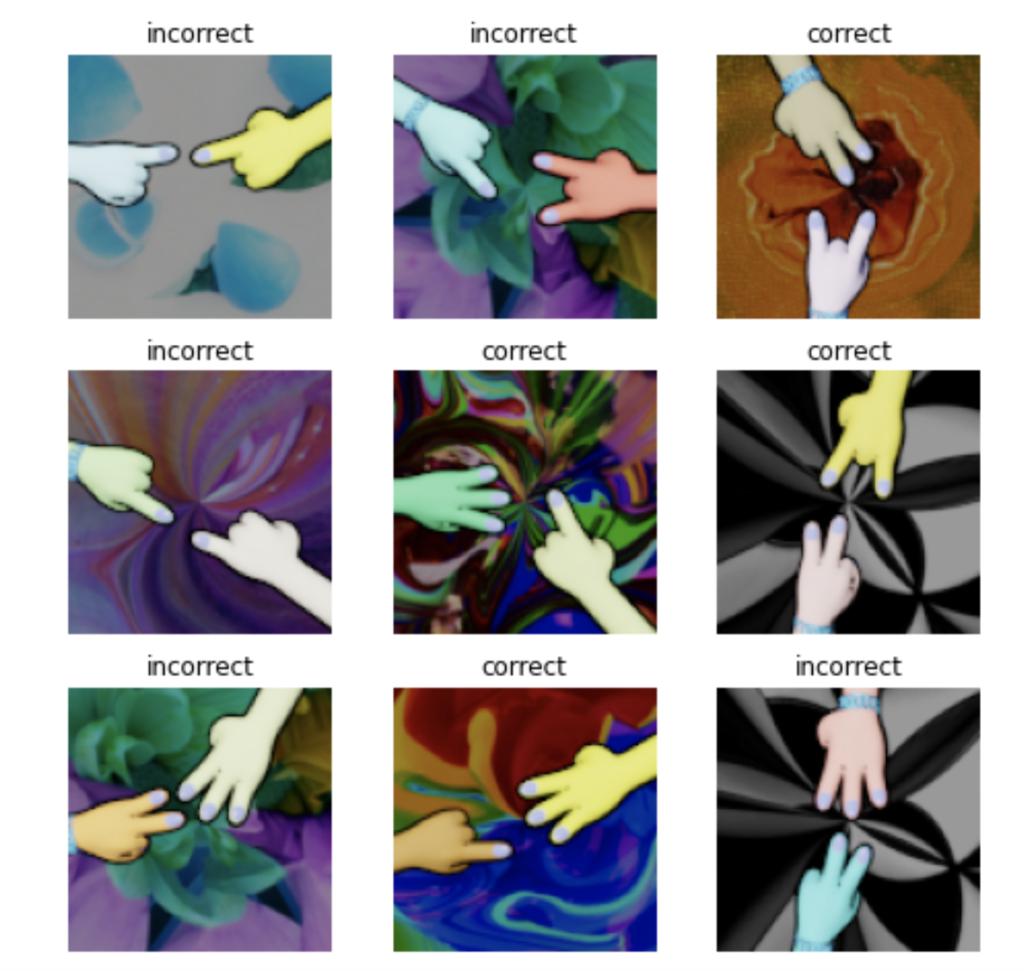

Pour démontrer les forces défensives et d'entraînement d'une image contradictoire, considérons une étude de cas, décrite ci-dessous. Cette étude de cas est un puzzle manuel, comme le montre la Fig.3. Les images correctes sont celles avec un total de quatre doigts, les autres sont incorrectes.

La méthode de perturbation contradictoire permet de créer l'une des images correctes, comme illustré à la Fig.4 ci-dessous. Un être humain peut ne pas remarquer la différence entre les deux images, à part une légère décoloration en bas à droite de la deuxième image. Le modèle d'apprentissage automatique, cependant, ne sera pas en mesure de reconnaître l'image et de la classer comme incorrecte.

Fig.3. Visualisation des données du puzzle de la main

La première image de la figure 4 ci-dessus est l'image originale (correcte). La deuxième image est l'image contradictoire (incorrecte). La troisième image montre la différence entre l'image originale et l'image contradictoire. La dernière image est la différence agrandie de la troisième image.

Force défensive

Nous testons les images avec les modèles d'apprentissage automatique les plus avancés. Nous entraînons ces modèles en interne avec une bonne précision. Les résultats sont comme indiqué sur la Fig.5. La précision du jeu pour le compartiment adversaire a diminué à environ 3 %, contre 8 % pour l'ancien ensemble d'images.

Fig.5. Précision du jeu de l'ancien seau et de l'adversaire contre l'attaque d'apprentissage automatique

Force de l'entraînement

Compte tenu de leurs prouesses technologiques, les attaquants sont toujours capables de collecter des images contradictoires et d'entraîner des modèles d'apprentissage automatique sur ces images. Un changement mineur de pixels dans les compartiments adversaires peut faciliter la formation des attaquants, ce qui peut être une source de préoccupation. La figure 6 montre que même avec un changement de pixel mineur, les modèles doivent encore réapprendre les images contradictoires.

Fig.6. Courbe de taille d'échantillon du compartiment nouveau et contradictoire pour la formation en apprentissage automatique

Dans une situation où les attaquants peuvent s'entraîner sur des images adverses, le flux peut continuer à ajouter du bruit au-dessus des images adverses avec les mêmes forces défensives et d'entraînement, comme décrit ci-dessus.

Vaincre les CAPTCHA automatisés avec perturbation adverse

Chez Arkose Labs, nous innovons constamment pour permettre à nos clients de garder une longueur d'avance sur l'évolution des tactiques d'attaque. En utilisant la perturbation contradictoire, nous les aidons à vaincre les solveurs CAPTCHA automatisés et à protéger leur entreprise et leurs consommateurs contre les attaques de robots automatisés. Pour savoir comment nous procédons, veuillez réserver une démonstration dès maintenant.

*** Ceci est un blog syndiqué du Security Bloggers Network d'Arkose Labs rédigé par ChunLiang Wu. Lisez le message original sur : https://www.arkoselabs.com/blog/adversarial-perturbation-to-defeat-automated-captcha-solvers/