Beaucoup de gens estiment que le développement rapide de la technologie dépasse souvent celui des structures sociales qui les guident implicitement et la régulent, comme le droit ou l'éthique.L'IA en particulier l'illustre car elle est devenue si omniprésente dans la vie quotidienne pour tant de personnes, apparemment du jour au lendemain.Cette prolifération, couplée à la complexité relative de l'IA par rapport à la technologie plus familière, peut engendrer la peur et la méfiance de cette composante clé de la vie moderne.Qui se méfie de l'IA et de quelles manières sont des questions qui seraient utiles à savoir pour les développeurs et les régulateurs de la technologie de l'IA, mais ce type de questions ne sont pas faciles à quantifier.

Des chercheurs de l'Université de Tokyo, dirigés par le professeur Hiromi Yokoyama de l'Institut Kavli pour la physique et les mathématiques de l'univers, ont entrepris de quantifier les attitudes publiques envers les questions éthiques autour de l'IA.Il y avait deux questions en particulier l'équipe, par l'analyse des enquêtes, a cherché à répondre: comment les attitudes changent en fonction du scénario présenté à un répondant et comment la démographie du répondant elle-même a changé les attitudes.

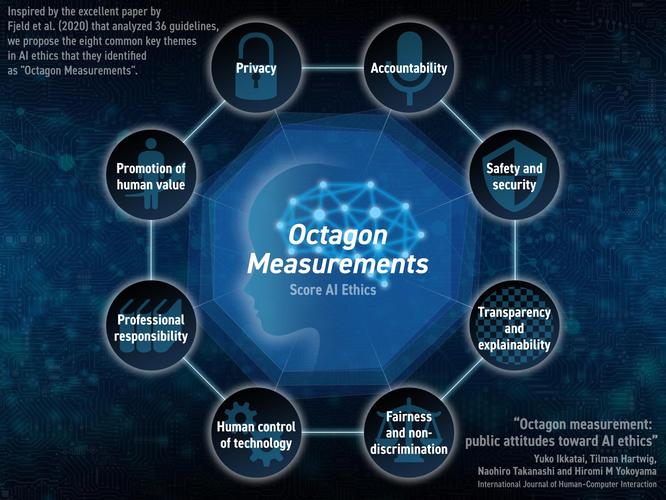

L'éthique ne peut pas vraiment être quantifiée, donc pour mesurer les attitudes à l'égard de l'éthique de l'IA, l'équipe a utilisé huit thèmes communs à de nombreuses applications d'IA qui ont soulevé des questions éthiques: confidentialité, responsabilité, sécurité et sécurité, transparence et explicabilité, équité et non-discrimination, humainContrôle de la technologie, de la responsabilité professionnelle et de la promotion des valeurs humaines.Ceux-ci, que le groupe a appelées «Mesures d'Octagon», ont été inspirés par un article de 2020 par la chercheuse de l'Université de Harvard, Jessica Fjeld, et son équipe.

Les répondants au sondage ont reçu une série de quatre scénarios à juger selon ces huit critères.Chaque scénario a examiné une application différente de l'IA.Ils étaient: l'art généré par l'AI, le service client IA, les armes autonomes et la prédiction du crime.

Les répondants à l'enquête ont également donné aux chercheurs des informations sur eux-mêmes, comme l'âge, le sexe, l'occupation et le niveau d'éducation, ainsi qu'une mesure de leur niveau d'intérêt pour la science et la technologie par le biais d'un ensemble de questions supplémentaires.Ces informations étaient essentielles pour que les chercheurs voient quelles caractéristiques des personnes correspondraient à certaines attitudes.

"Des études antérieures ont montré que le risque est perçu plus négativement par les femmes, les personnes âgées et ceux qui ont plus de connaissances sur le sujet.Je m'attendais à voir quelque chose de différent dans cette enquête compte tenu de la façon dont l'IA est devenue banale, mais étonnamment, nous avons vu des tendances similaires ici ", a déclaré Yokoyama."Quelque chose que nous avons vu qui était attendu, cependant, était de savoir comment les différents scénarios ont été perçus, l'idée que les armes d'IA se réunissent avec beaucoup plus de scepticisme que les trois autres scénarios."

L'équipe espère que les résultats pourraient conduire à la création d'une sorte d'échelle universelle pour mesurer et comparer les problèmes éthiques autour de l'IA.Cette enquête était limitée au Japon, mais l'équipe a déjà commencé à collecter des données dans plusieurs autres pays.

"Avec une échelle universelle, les chercheurs, les développeurs et les régulateurs pourraient mieux mesurer l'acceptation de demandes ou d'impacts spécifiques de l'IA et agir en conséquence", a déclaré le professeur adjoint Tilman Hartwig."Une chose que j'ai découverte en développant les scénarios et le questionnaire est que de nombreux sujets au sein de l'IA nécessitent une explication significative, plus que nous ne l'avons réalisé.Cela montre qu'il y a un énorme écart entre la perception et la réalité en ce qui concerne l'IA."